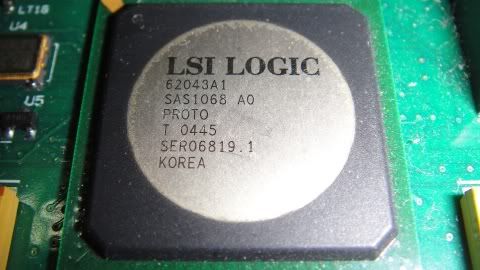

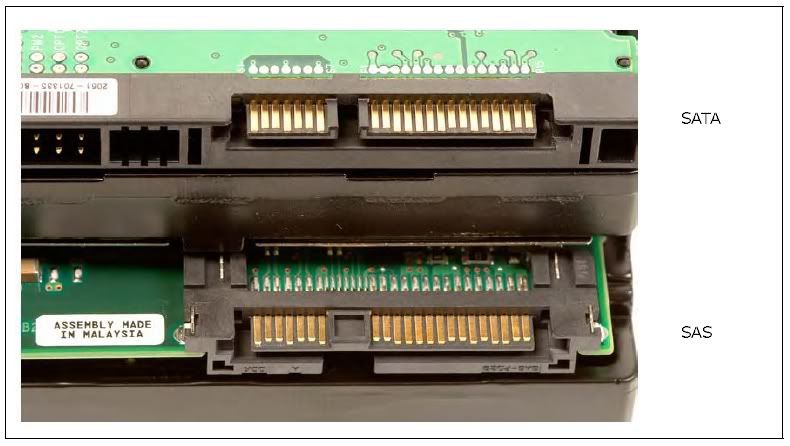

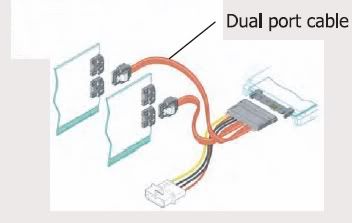

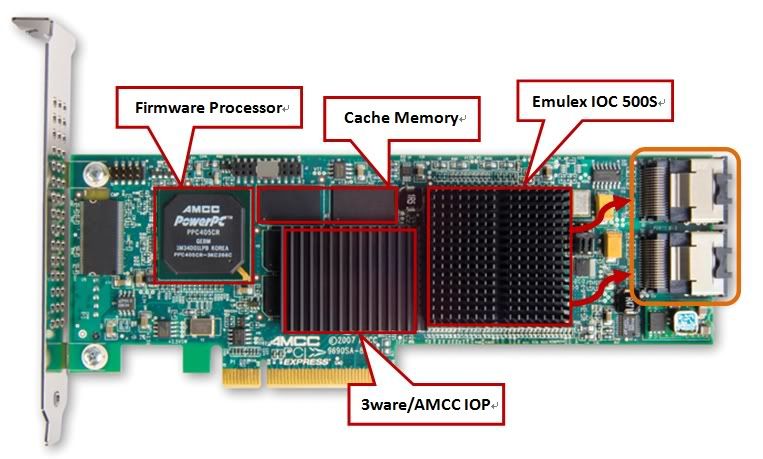

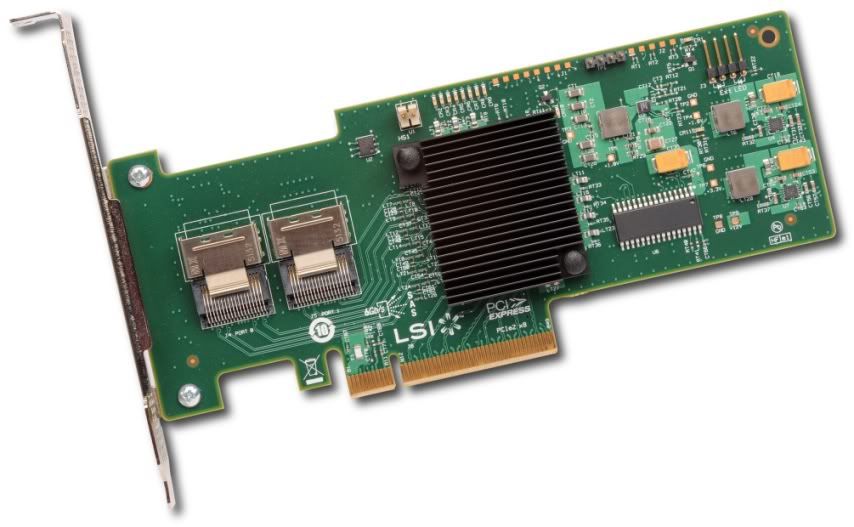

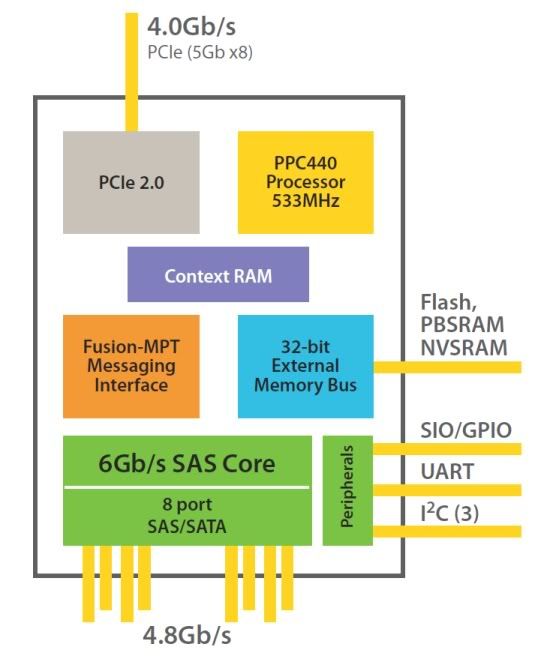

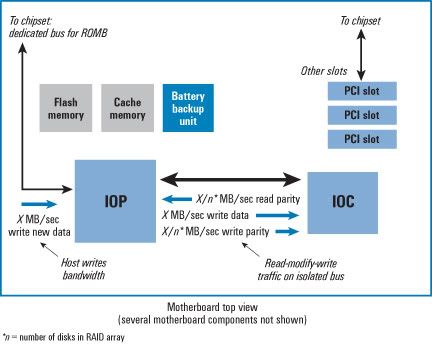

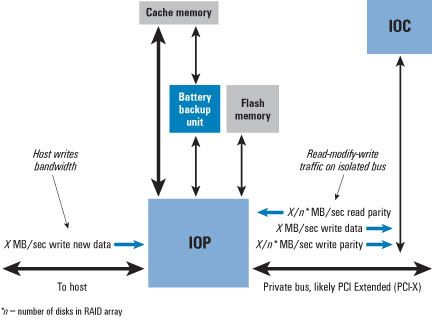

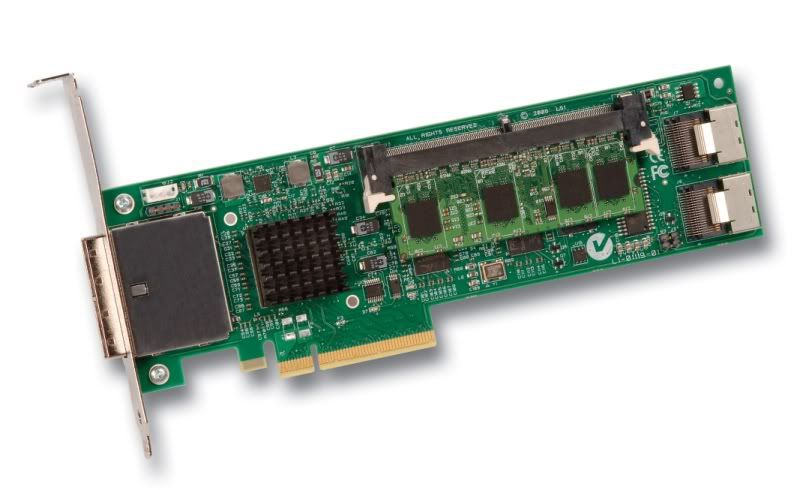

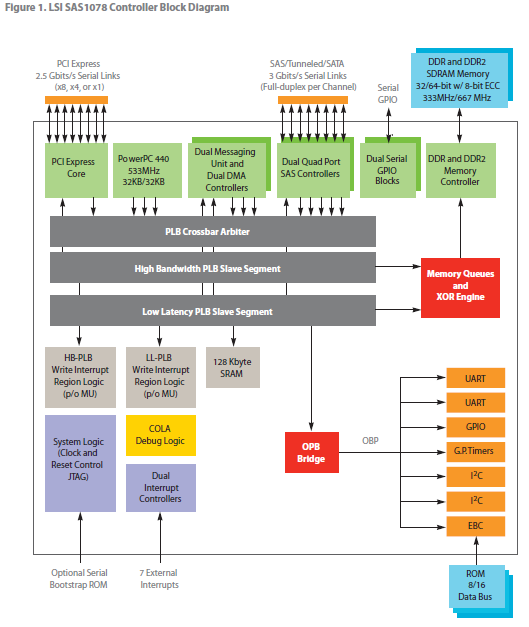

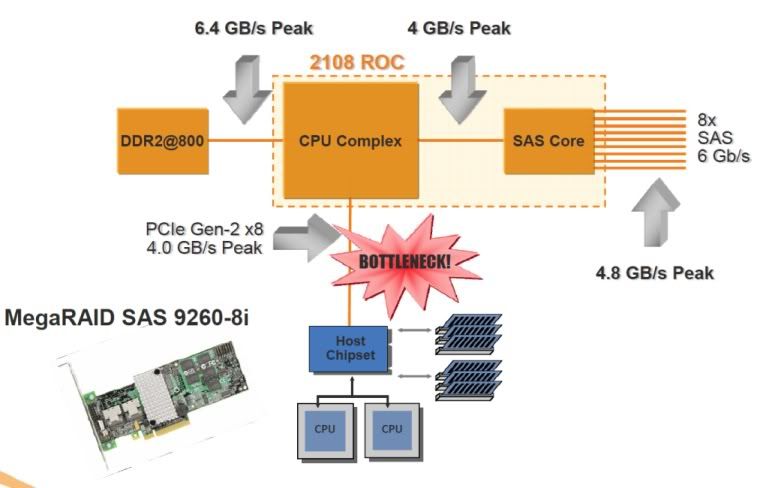

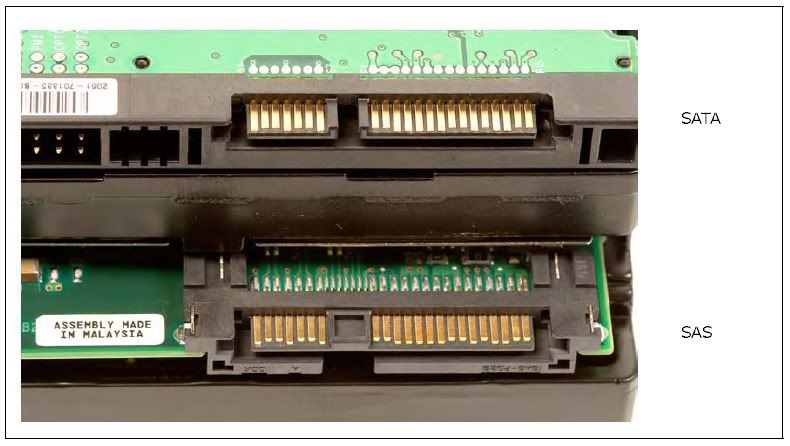

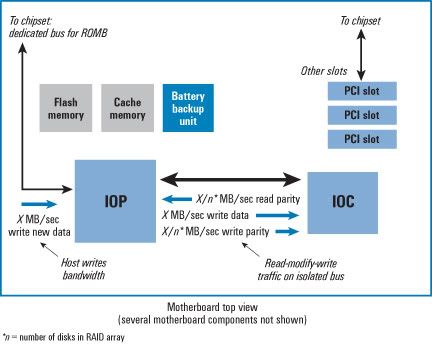

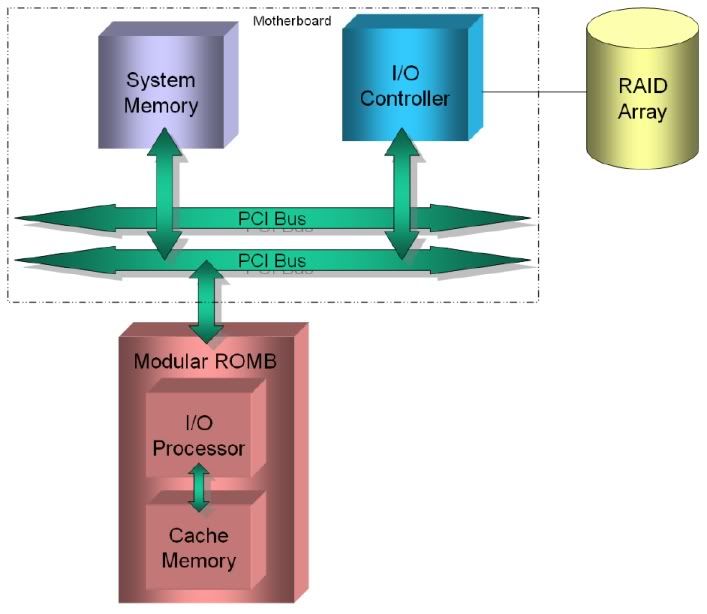

| PCDVD:vxr  | RAID硬體資訊收集...!! 之前就想寫這個來做備註了。在此先標記起來,做為以後遺忘備用查詢...XD。 順便供各位參考! 大致上提供一些重點廠商資訊(只針對SAS和SATA).. 不定期會增加資訊.. 先上廠商大綱及編排基本版面.... 內容晚點慢慢補=__=" 已編入至OSSLab: http://www.osslab.org.tw/Storage/Ent...S%e8%88%87RAID 歡迎各位前來觀賞... ================================================================ 基礎資訊 SAS/SATA HBA和RAID HBA HBA為Host Bus Adapter,作為介面卡的通稱,可能是網路卡、音效卡、存取儲存裝置的控制卡,其實無非著眼於Host Bus這個字眼,規定了對Host Bus界面上的支持。 SAS/SATA HBA作為與I/O Storage連接的最基礎方式,最大目的無非就是與Storage存取。SAS/SATA HBA對於支持的Host Bus規格與HDD連接器(Connector)介面規格則視該晶片的硬線設計而定,Host Bus面對的也許是PCIe或著PCI-X,而HDD連接器介面規格則是SATA或著SAS。SAS/SATA HBA決定了對連接器數量的限制,例如某個SATA HBA對於SATA Port的支持數量。我們以Silicon Image的低階SATA HBA基本結構圖來表示,如下:  而這張是因為韌體關係而使其成為一種SAS/SATA HBA的LSI SAS控制卡實物:  採用LSI1068晶片  這張是使用LSI1068的晶片,本身的SAS控制器提供了wide port x2支持,內置一顆ARM的IOP(@225MHz,印象中是這樣),賦予基礎的RAID 0和RAID 1(LSI1068E的增強版提供了RAID 1E消費成本較高的模式,對於IOP的負載量會提昇),另外有一個ZCR的支持。上述照片中的產品,由於韌體的關係,使其成為單純的SAS/SATA HBA,RAID功能完全被廢掉。 [table]Dual-Port設計:SATA和SAS物理規格上的最大差異 Dual-Port可以說是SAS獨有的特徵,這個設計實際上只有兩種主要作用: 1.防呆設計 2.提供容錯 防呆設計的作用,其實很簡單,就是防止SATA HBA插到SAS Storage,因為SATA的protocol並沒有辦法兼容SAS protocol,下面是一張SATA的引腳圖:  從Host Connector這部分可以看到,他有一個sideband去將signal connector和power connector去間隔開來,在右邊圖部分有一個SATA Connector模型包含了大4pins的12v電源接頭,我想這大家都知道,這是為了早期去保持相容性而設計的。接下來我們來看看SAS Connector的引腳圖部分:  可以看到SAS Drive Connector部分,與SATA Drive Connector相比,他多出了一部分的backside,這個backside作用於第二條的secondary link,也就是說在SAS Connector下,包含兩個signal connector和一個power connector,兩個signal conntecor作為一個是primary和secondary,由於多出了一個backside導致SATA HBA或著SATA Controller on Motherboard 無法連接在SAS Port上,保證了某些情況下SATA cable不會誤接在SAS Drive Connector上。我們以一張SAS HDD和SATA HDD的Connector比較圖來示意其差異部分,如下:  而以下我們從兩張圖來說明一些問題,下面是SAS protocol基本示意圖:  來看看SATA protocol的示意圖:  已經知道SAS的Drive Connector設計以致SATA HBA無法連接,前面說過這樣做目的之一為了防呆,但是為什麼要防呆呢??基於這個理由,稍微探究一下為何要這樣做!其實從上面兩張協定圖框起來的link layer,可以發現差異,SAS多了STP協定,STP全名為Serial ATA Tunneling Protocol,STP協定最大目的就是為了讓SAS兼容SATA裝置,而在SATA protocol根本不需要這種自我矛盾的協定,另外包括SMP(針對Expander部分)和SSP(針對SAS部分)這兩種協定,這兩個協定也是跟SATA完全不合,因此,從這邊已經可以決定了SATA HBA是完全無法連接在SAS HDD。 對於Dual-Port設計的第二個目的-提供容錯,這是Dual-Port設計最大的目的,前面有提到,SAS Drive Connector中的backside拉出的引線作為secondary link,這兩個link表示著SAS HDD被賦予了兩個"實體連接",這樣的做法,我們用以下的圖來表示其應用性:  這是一個典型的Dual-Port應用模型,可以得知當一張SAS HBA故障的時候,並不會導致該SAS HDD無法正常使用,而是透過另一張SAS HBA來確保SAS HDD的資料安全性,可以理解到Dual-Port設計確實提供的某種程度的容錯以及可性用的增強,不過很多情況下,Dual-Port設計並沒有得到太大的實務應用。不少backplane單純只有Single-Port設計,並沒有Dual-Port設計,以至於這樣的功能形同虛設。[/table] 在以RAID HBA的角度來看,它是從單純的SAS/SATA HBA上提供了RAID功能(RAID 0, RAID 1, RAID 5, RAID 6,甚至是混合模式),有些RAID HBA裝置在單顆HDD下還是可以識別使用(通常是沒有內置IOP),另外有些RAID HBA,就是得必須建立陣列才能用(如果HDD本身有資料存在的話,必須事先備份)。下面是一張LSI/3ware的早期9690SA-8i H/W RAID HBA卡,這是一張硬體RAID,是由PPC+IOP+IOC組成經典的StorSwitch結構,在3ware還沒被LSI併走以前,一直都是用這種結構:  很多人以為那個PPC405R是IOP(@266MHz),連我當初以為也是=_=,其實這顆PPC處理器是用來操作韌體(Firmware)代碼用的(左邊那顆),真正作用的IOP部分在中間那顆被散熱器蓋住的晶片,可能是與9650SE同款的處理晶片-3ware/AMCC G133 RAID Engine(True Hardware RAID),因為一樣都標明8th-generation StorSwitch架構,故猜測可能是相同的,而且G133 RAID Engine並非從9650SE開始用的,所以是蠻古老的。不管如何,9690SA是真正的Hardware RAID,並且提供BBU支持。而下面這張是LSI 9211-8i的RAID HBA卡,提供基礎的RAID功能,在單顆HDD的情況下,可以被識別直接使用:  注意!這顆用的晶片是LSI 2008,它是一顆RoC架構的晶片,所以是Hardware RAID架構,內置PPC440(@533MHz)的IOP,基本上是可以提供RAID 5模式,但是因為韌體的關係,並不提供RAID 5功能,因此IOP部分僅在消費成本較高的RAID模式下才比較有效益(而且Block Size還是固定的,不能調整=.="")。 在某些廠牌的工作站/伺服器主機板也提供這塊晶片(這種其實可以稱之為ROMB方式),Host Bus用PCIe Gen2 Lane x8去連接他,例如Supermicro的X8SI6-F,不提供RAID 5模式,預設模式為IR(Integrated RAID)模式,但透過一小塊的RAIDKey去啟動並切換至IMR(Integrated MegaRAID)模式後,便可以得到支持,如下圖所示:  透過RAIDKey方式啟動後,便可提供RAID 5模式,且允許Block Size彈性調整(最大只能到64KB),支持SSD Guard技術,但是因為切換成IMR模式後,在單顆HDD情況下,沒辦法被識別使用了,必須要建立陣列才行。下面是一張LSI MegaRAID SAS 9240-8i的RAID HBA,歸屬於MegaRAID產品線,所以可以提供對RAID 5模式的支持:  在提供對RAID 5模式支持後,在單顆硬碟情況下無法被識別直接使用,而BIOS模式與SAS 9211不同,提供的是MFI(MegaRAID Firmware Interface)操作模式。 這是一張LSI2008的方塊圖結構,如下所示:  可以看到LSI2008支持到wide port x2,裡面有一塊-Fusion-MPT,這是LSI專屬的I/O通訊架構。 [table]ROMB設計:比RAID HBA/ZCR更具有成本優勢 ROMB全名為RAID on Motherboard,意思就是主機板(Motherboard)上做一個RAID的子系統部分,與RAID HBA相比較,它具有更大的成本優勢。現成板子上的layout設計,元件配置的最佳佈署,成本化的取捨考量。以一張RAID HBA搭配主機板,例如Supermicro X8SIE-F搭配LSI MegaRAID 9240-8i,實際成本會遠高於一張Supermicro X8SI6-F與Supermicro AOC-SAS2-RAID5-KEY的組合,由於這樣的價格優勢,ROMB設計是一些做高端主機板廠商會採用的方式,例如前面提的UP Xeon系列板子-X8SI6-F,即是如此!  這樣的設計雖然立意上不錯,但是免不了會有缺點上的存在,就是沒辦法基於這個RAID子系統上再加以硬件式擴充升級,最多只有通過韌體(Firmware)更新的方式提供新的特性以及一般性問題修正(The primary disadvantage of ROMB is the lack of hardware upgradeability, although features and performance can generally be upgraded in firmware.)。當然!ROMB的設計也可以避免一些相容性的問題,因為一切決定於主機板廠商。下面的示意圖表示ROMB的模型架構:  可以看到整個元件配置皆佈署在主機板上,這是實作RAID(RAID implementation)系統的另一種典型模式!成本優勢上的設計方案。下面這張是Broadcom的ROMB文件提供的簡易模型:  以一般主機板上透過南橋晶片(South Bridge)提供IOC,利用RAID Option ROM寫入至NVRAM讓BIOS提供RAID功能,例如像Intel的ICHxR實務設計-Hardware-Assisted Software RAID。其實算是一種ROMB,個人認為,ROMB設計沒有強制規定要Hardware RAID,因此,只要是在主機板上提供RAID功能,都可以算是ROMB。 [/table] RAID HBA通常分成兩種形式:Software RAID和Hardware RAID,我想這玩過或著知悉一些RAID知識的人都應該知道,在說明這兩個模式之前,並不包含到一些古怪的產品實務設計,例如某家RAID卡廠商(H開頭)早期某幾款提供某種程度的XOR硬線加速設計來提高I/O性能。 Hardware RAID比較好講,基本的架構就是IOP+IOC的組合,IOC可以說是SAS/SATA HBA部分,IOP通常只是拿來加速運算用的。Hardware RAID的部分,我們稍後再提,先來講講Software RAID,根據Adaptec早期提供的一份基礎文獻(Hardware RAID vs. Software RAID: Which Implementation is Best for my Application?),對於了解Software RAID和Hardware RAID差異是值得參考的,就Software RAID的特徵,Software RAID拆成兩個部分:Pure Software Model – Operating System Software RAID和Hybrid Model – Hardware-Assisted Software RAID。在Pure Software Model下,這個模式是非常容易瞭解的,RAID功能與實作上的決定完全取決於作業系統而定,此模式提供最低成本的考量,但是缺點不少,最大的缺點在於他I/O性能不佳,而且受到Software層級上的限制,意味著它容易被作業系統綁死,下圖是一張Pure Software Model的基礎示意圖:  Pure Software Model在一般情況下,是不會去應用的,尤其最近這幾年來,Hybrid Model – Hardware-Assisted Software RAID反而是最常被用到的,基本上就是SAS/SATA HBA with a RAID BIOS或著是RAID BIOS integrated onto the motherboard,例如Intel的ICHxR就是一個Hardware-Assisted Software RAID,透過額外的硬體加入RAID的支持(將RAID Option ROM寫在BIOS裡),RAID功能部份可以獨立於作業系統,資料安全上也高於Pure Software Model,透過系統啟動BIOS初始化階段,可以預先檢測到RAID模式的狀況,並且提供獨立的GUI設定RAID組態,當然在某些RAID模式下,IO性能依然會受到限制,例如典型的RAID 5模式。下面是一張基本的示意圖:  這張描述的是以HBA with a RAID BIOS的模型,RAID Software與HBA部分包起來,RAID Software意指著將有關RAID代碼部分寫在NVRAM裡,作為系統啟動初始化的時候,獲得RAID的相關功能,也包括專屬的組態設定(dedicated GUI and software to build and maintain the RAID)。 這張是我取自DELL網站加以修改的基本HBA with a RAID BIOS結構:  另外這張表示圖則是ICHxR實現RAID功能,將RAID Option ROM寫到主機板上的System BIOS裡,以提供RAID Configuration Utility建立RAID:  Software RAID的相反就是Hardware RAID,如之前所提,典型就是IOP+IOC(A Discrete RAID Controller Card)的組合,IOP作為某些模式(例如RAID 5)的運算加速時,可以提供某種程度上的效益(得視該硬體處理性能而定),並且IOP會包含一些額外的硬線加速設計,當然Hardware RAID花費的建置成本都高於Software RAID,以下是來自DELL的IOP+IOC示意圖:  這種結構大多都會包含對Cache Memory的支持,藉以提供Read/Write Cache算法來增強I/O性能,透過BBU來提供某種程度上的資料安全性。幾年前IOP+IOC的分離設計代表最經典的就是Intel IOP333,也就是說IOC部分透過額外的RAID HBA晶片來連接,以下是IOP333的方塊圖:  上述有一個AAU(Application Accelerator Unit),這個硬線加速設計可以增強RAID6的運算性能,但是IOP333面臨到的最大瓶頸問題在於IOP與IOC之間的連接頻寬,基本上是透過PCI-X拉過去的,最大提供1GB/s的帳面有效頻寬,這反而成了I/O性能上的問題,原因很簡單!就SAS 1.0規範來說好了,一條narrow link連接到Storage所支持的帳面頻寬為3Gbps,而wide port包含4 narrow links,3Gbps x4=12Gbps=1.5GB/s,在1.5GB的頻寬下早就打爆PCI-X了,當然實際情況不是這樣,一個wide port還不太容易衝爆,但是wide port x2的結果就不一定了,PCI-X頻寬不敷使用也是遲早的事。如下圖來自DELL PERC 5文件所示:  可以看到使用IOP333與IOC接通,IOC是使用LSI1068控制晶片,LSI1068面對的Host Bus支持為PCI-X,IOP333與LSI1068之間的頻寬只有1GB/s,導致連接多顆Storage後,性能上的問題會愈來愈嚴重。以下是經典的DELL PERC 5:  IOC部分則是使用LSI1068(沒蓋散熱片的那顆),提供SAS/SATA HBA功能,在另一款的LSI 8344ELP也是這樣的設計,主要差別在於Connector連接規格不同與Cache Memory的可擴展性,如下圖所示:  下面這張是早期Adaptec優秀的IOP333產品-4805SAS:  IOC部分是採用與Vitesse合作的AIC-9410W晶片,提供wide port x2(4 narrow links/per port)。 這張是相反的4800SAS,採用的IOP為IOP331:  IOP331面向的Host Bus為PCI-X,結果跟4805SAS是一樣的。 另外3ware經典的StorSwitch結構也是IOP+IOC的分離設計,而且韌體代碼的操作交由獨立的PPC來處理,下面是一張3ware的9650SE-2LP:  最左邊包含了PPC+韌體部分,中間則是一顆IOP,最右邊是Marvell的IOC,來提供對Storage的連接,這張好幾年前有玩過,實在不怎麼樣的玩意兒,Host Bus部分為PCIe Gen1 x1,頻寬很小,提供Cache Memory支持,但是BBU功能被拿掉,且Connector是discrete的,也就是2 SATA ports,價格到現在還不便宜,因此可以列為最不划算的RAID產品之一XD。 Intel從IOP33x之後,大幅改進推出IOP34x的優秀產品,這是一個RoC架構的產物,基本上IOP與IOC完全被整合,所以不必考慮之間的頻寬問題,以下是IOP348的方塊圖:  IOP34x是雙處理器結構,並且整合IOC部分,提供wide port x2(4 narrow links/per port),Cache Memory支持DDR2-533規格。RoC架構是這幾年的發展趨勢,雖然他不是創新的架構,不過這一兩年來的RAID硬體發展可以說是他的天下。下面是Areca的優秀RAID產品-ARC-1680ix-24:  可以看到這款可以支持到2 wide ports以上,因此這絕對是透過SAS Expander方式(右邊的那顆晶片)去擴展更多的wide port來連接大量的Storage。 RoC架構的一個經典產品是LSI的1078系列,下面可以看到一張來自DELL對PERC 6採用LSI1078的基本結構圖,事實上它是用來跟IOP333產品-PERC 5去做比較:  PERC 6是前一兩年當紅的產品,因為它比LSI同期產品還要便宜不少,加了BBU也沒多加少錢,要注意!LSI的BBU實在貴到翻掉=_="",一塊就擁有跟LSI 8888ELP(LSI1078)差不多的性能,缺點是相容性上的問題要注意。  DELL PERC 6,Connector規格標準為非主流的SFF-8484標準,256MB DDR2-667 Cache Memory,後期的韌體支持SSD Guard(印象是要刷LSI的firmware...)。下圖則是前幾年LSI Internal/External RAID最高端的產品-MegaRAID 8888ELP:  Connector規格標準為現今主流的Internal SFF-8087 x2和External SFF-8088 x2,透過SAS Expander連接可以達到240個Storage,Cache Memory可擴展,最高可以達到1GB,在當時無論如何都是非常強悍的RAID產品。而關於LSI1078的方塊圖如下:  基本上塞一顆PPC440(@500MHz)的IOP,還包含了XOR Engine的硬線加速設計。LSI1078目前的最大缺顯在於Host Bus的頻寬瓶頸,因為PCIe Gen1 x8最大僅能支持到2GB/s的帳面有效頻寬,明顯略有不足,在後來的LSI2108就改善了這個問題,透過PCIe Gen2 x8提供了4GB/s的Host Bus帳面有效頻寬,可以說是大幅緩和!如下基本示意圖所示:  LSI2108不僅僅是提高了PCIe頻寬的需求,並且提升了PPC440的性能(@800MHz),Cache Memory的支持提供到DDR2-800。下面是一張性能極為優秀的LSI MegaRAID 9260-8i:  當然價格也是相當難看,而且BBU這部分實在貴得離譜,一顆BBU07要將近9k=.="",性能是很好沒錯,不過整體價格實在是OOXX的。 目前拿Intel和LSI的例子來舉,僅是說明RoC成為這幾年來發展的主流,當然並不單單是只有這兩家,另外還包括了Marvell的88RC9580和PMC-Sierria的PM8011。 另外Intel目前已捨棄ARM架構的Xscale IOP設計,轉向以Nahalem架構為主的x86架構(Xeon C5500/C3500[Jasper Forest]),走的方向也比較與眾不同,HBA部分透過SBB總線架構用來與Backplane(with SAS Expander),SBB連接至Backplane提供相當高的I/O傳輸頻寬,對於一個mini-SAS Port的連結達到24Gbps的頻寬(並不一定如此,得視硬體設計!),不過現階段看到的透過x86 CPU僅能加速RAID 5/6運算性能,沒有包含對SATA/SAS連接器上的支持,依然還是得透過外接SAS/SATA HBA來提供(例如使用LSI2008作為IOC上的支持),而且x86架構的情況下,整個配套的軟體方案就顯得更重要了,就個人詢問得知目前比較完善在Linux部分,Windows部分還是有待加強,這是我所得知的部分。以下是自繪的SBB架構的一部分:  可以看到,透過Intel C5500/C3500[Jasper Forest]提供了一種XOR/P+Q硬線加速設計,用來提升對RAID 5/RAID6的性能,由於並沒有IOC的部分,必須另外接一塊做連接,例如這邊可以連接LSI2008作為與SAS Expander的溝通,最後利用SAS Expander透過Backplane與Storage建立連接(通過AMC)。 如果把Intel排除的話,那這幾年的Hardware RAID設計可以說是殊途同歸,清一色都是RoC架構,不管是LSI/3ware、Marvell、Areca(採用Marvell RoC)、Promise(採用PMC-Sierria RoC)或著PMC-Sierria/Adaptec等等...,都是朝向這個方向發展,這不僅僅是性能上的提升,高度整合對於成本上的控制也有所助益,整個PCB的規模也有助於精簡。此外,SSD的逐漸發展,也將為成為各家RAID廠商的優化議題,尤其以LSI來說,提供的LSI優化方案較為齊全,Advanced Software Options包含了兩項對於SSD的最佳實作,當然這些都是要購買License的,至於其他,被PMC-Sierria買下來的Adaptec先前也提供一種MaxIQ技術,只是這種技術花費成本相當昂貴。而Marvell在較低階的88SE9128也將會提供類似MaxIQ的低成本混合加速技術-HyperHDD,事實上這一顆晶片有整合名為Sheeva的ARM處理器,理論上是可以提供對RAID 5的支持,並且可以透過Port Multiplier方式來使用,所以姑且應該算是一顆Hardware RAID吧。  大致上關於SAS/SATA HBA和RAID HBA,所想到的就這些(以後還想到甚麼再去補..)。接下來就是一些RAID硬體資訊的收集,往後作為備忘查詢之用途XD! ================================================================ 參考文獻: *Hardware RAID vs. Software RAID: Which Implementation is Best for my Application? *SAS Raid-on-Motherboard: Affordable, High Performance RAID *Take the Lead with Jasper Forest, the Future Intel®Xeon®Processor for Embedded and Storage *Intel Explaining Hard Drive Differences *SAS Integrator Guide *Serial Attached SCSI Physical layer *Serial Attached SCSI Link layer – part 2 *Introducing the Dell PERC 6 Family of SAS RAID ControlLers *An Evolutionary Step for SAS Technology *Serial Attached SCSI Cables and Connectors *SERIAL ATTACHED SCSI-A White Paper Prepared for the SCSI Trade Association *The Benefits of RAID on Motherboard http://www.dell.com/content/topics/g...luse?c=us&l=en *Port Multipliers http://www.serialata.org/technology/...ultipliers.asp 此篇文章於 2010-07-10 11:19 PM 被 per1 編輯。. |

| 回覆 |

| PCDVD:vxr  | 回覆: RAID硬體資訊收集...!! 此篇文章於 2010-10-28 11:25 AM 被 per1 編輯。. |

| 回覆 |

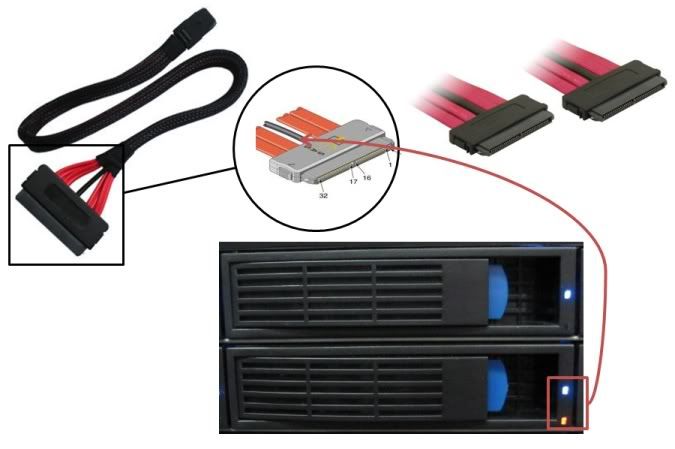

| PCDVD:vxr  | 回覆: RAID硬體資訊收集...!! 這邊作為灌水雜文(草稿)..... 用以來作為將來補充文章之備用...XD Port Multiplier    SAS Standard Layer  SATA 1.0a Standard Layer  ATA/ATAPI-7 standard layering  SATA device connector  SAS plug and backplane receptacle connectors  SATA and SAS Hard Drive Connectors  ROMB   ZCR/MROMB   此篇文章於 2010-07-05 11:04 PM 被 per1 編輯。. |

| 回覆 |

| PCDVD:vxr  | 回覆: RAID硬體資訊收集...!! Host Connector與Drive Connecter之間透過一條Cable相連接,Cable的形式決定了Connector的規格。在SATA的標準下,很單純!即為單點對單點,不支援wide port設計,非多點起發者,因此SATA的設計大致上只有看到SATA和eSATA規格。不過在SAS標準下就不一樣了,SAS支持wide port設計,成為多點起發者,作為企業之應用,比起SATA標準有更多的考量。Cable的標準意味著Connector的規格必須一致,SAS下採用SSF委員會所制訂的標準,隨著時代的變化,標準也更著不同。我們針對Connector與Cable規格這部分,大致上歸納三大類: 1.Internal *SFF-8484:Internal Multilane Connector and Cable *SFF-8087:Internal Mni Multilane Connector and Cable 2.External *SFF-8470:External Multilane Connector and Cable *SFF-8088:External Mni Multilane Connector and Cable 3.Other *變化型,這類計通常搭配前面兩大類做不同的組合。 在說明各種Cable標準以前,我們不妨來探究一下在SAS協定中的實體層(Physical Layer),是如何定義Connector訊號,下面的一張圖用來表是為SAS Drive Connector的引腳訊號表:  可以看到提供了兩條實體連接用以提供容錯,這個在之前已經說明過,故不在重述。我們再來看看Host Connector部分,如下圖所示:  從上圖理解得知,大多情況下,Host Connector(非連接backside部分)對應Drive Connector的Primary phy link(Secondary phy link有相關限制),兩者之間建立起一條narrow link,之前多多少少都會提到wide port和narrow link這兩個字眼,在SAS的規範下是支持wide port設計,這根SATA規範是完全不同的,透過wide port設計可以允許4條narrow link連結到各Storage,從以下的Internal Wide Connector引腳訊號表描述這樣的設計:  可以看到這樣的wide port設計可以支持4條narrow link,並且基於SAS協定中的SMP協定,允許您透過wide port連接到Expander去擴展更多Storage。在那張圖的中間可以看到sideband的部分,這部分可以做為SGPIO訊號的發送輸出,對於使用抽取模組機箱來說,他是極為有用的設計,可以用來控制LED狀態去做判斷,不過使用這個前提就是backplane必須帶有SGPIO輸入,且SAS Cable也必須包含SGPIO輸出接線。 由於wide-port的設計,導致了到現今為止各種不同組合的cable設計,在SCSITA組織提供的一份文件-SAS Integrators Guide,指導了各種cable設計與連接方式,透過這份文件,我們來解釋不同的設計。 在早期SATA HBA是最早被廠商採用的設計,那時SAS還沒有正式出來,在RAID HBA部分,來看Areca的一張IOP331產品-ARC-1120:  這張Cache Memory為DDR333 256MB、IOC為Marvell的,可以看到他支持SATA Port x8,這是一款PCI-X規格產品,因為IOP331面向的Host Bus僅能PCI-X。先不管這款產品性能規格如何,我們先看看他的SATA port配置,這是一種堆疊設計結構,雖然這樣的設計有助於PCB規模的控制,但是也帶來了不必要的麻煩。當連接大量的SATA Storage時,對於整線會造成困擾,且還有SATA port的抽拔問題。比起Areca這款ARC-1120來說,我們來看看更棘手的產品,如下:  這是3ware的一款RAID HBA-3 ware 9550SX-8LP,StorSwitch架構、PPC405CR和G133 RAID Engine,可以看到這款的最大問題在於SATA port的配置,這樣的配置可以說是極為失敗,雖然採用雙面堆疊設計有助於PCB面積的控制,但是SATA port擺的位置實在不佳,除了整線上的困擾,SATA port的抽拔問題更是麻煩,小弟不明白為什麼要這樣設計。而再來看看3ware的另一款RAID HBA產品-3ware 9500S-8:  這是舊款的RAID HBA產品,可以想想早期3ware不少產品都是一堆port,主要在於StorSwitch所展現的優勢,不過看看這款的SATA port是開放式的,也是堆疊結構,在整線上稍微麻煩了些,但是至少抽拔部分不會比前面兩款還難處理,只是要注意的就是安全性問題,因為一不小心就有可能會把Host Port毀損,這是小弟親身體驗過(手賤??),血淋淋的例子。 在SAS出來之後,Connector規格是由SFF委員會所提出的,在前期SAS所採納的Connector標準,Internal形式部分為SFF-8484;External形式為SFF-8470。這兩種都是一種wide port設計,支持4 narrow links。在SFF-8484標準下,接口採用扇出(fan-out)的形式,這樣的設計,讓Connector會比較寬一些,如下圖所示:  雖然SFF-8484集縮了4條narrow links,但是這樣的扇出設計還是不利於整線,而Connector面積比離散(discrete)的SATA port面積還要大,有些實務設計,反而會增加PCB面積,提升成本。例如以下這張產品:  這是一張LSI的SAS HBA-MegaRAID SAS 8408E。採用IOP333,支持DDR2-400 256MB Cache Memory,IOC部分不用說了,當然是自家的LSI1068。可以看到這張卡的實務設計有一個問題,就是PCB規模部分,由於SFF-8484的設計方式,反而大幅增加對PCB的面積, 提升成本。而且,周遭都有安裝其他HBA的話,在插拔上來說還頗麻煩的,就這些幾乎跟SATA Connector設計一樣的缺陷,因此,微縮化的設計勢在必行,之後提SFF提出了8087標準,也就是很多人常稱呼的Mini-SAS。下面是一張基本的SFF-8484標準的cable:  而這張SFF-8484 cable則是較為高檔的Round Cable,相較於基本款,較有利於整線上的配置:  還有一種則是帶有SGPIO輸出的設計,對於採用背板抽取模組來說,是極為有幫助的,藉由SGPIO,透過SAS Hot Plug Tray帶有LED,可以得知當前的HDD狀態。如下圖:  上圖那張SAS cable作為SFF-8484轉為SFF-8087設計。 先待續=..=晚點很快補... 此篇文章於 2010-07-10 10:01 AM 被 per1 編輯。. |

| 回覆 |

| 我是嫩咖 | 回覆: RAID硬體資訊收集...!! 好文,值得收藏,謝謝分享。 |

| 回覆 |

| 嘴炮戰隊隊長 | 回覆: RAID硬體資訊收集...!! 好文加一,值得閱讀。 |

| 回覆 |

| 版豬 | 回覆: RAID硬體資訊收集...!! VXR 大這篇不錯..有空我把這篇文章收入到我們網站,與你一起改寫方便嗎? 我補充一下 (IOP), a dedicated XOR engine (IOC). I/O controller PMC Sierra // HP P410 Raid card Lsi 跟3ware產品線要分開 !!!! 二家硬體可完全不同 另外(Xeon C5500/C3500[Jasper Forest]) 我個人覺得應該在Linux 下是fake raid.. 這可是不小問題.. |

| 回覆 |

| PCDVD:vxr  | 回覆: RAID硬體資訊收集...!! 引用:

ok....... Lsi和3ware我有考慮過分開.. 但是因為3ware已經被lsi買走了.. 所以我就乾脆寫在一塊了... 而且3ware的RAID硬體資訊實在不太好查... 尤其那個稱為P-Chip的IOP... 詳細資訊幾乎找不到.. 只知道他有一個Multi-DMA Channel結構的硬線設計,可以說是一個DMA Pool... "我個人覺得應該在Linux 下是fake raid.. 這可是不小問題".. 詢問過... 算是一個Software RAID.. 其實性能還是不如Hardware RAID=.=""... 此篇文章於 2010-07-02 01:43 AM 被 per1 編輯。. | |

| 回覆 |

| PCDVD:vxr  | 回覆: RAID硬體資訊收集...!! 3ware部分... 得整個產品一起上.. 有幾個原因: 1.關於他的詳細資訊難以尋得=.="" 那顆中間類似IOP之作用的晶片,之前找了很久找半天...... 往回從之前的9650SE開始找.. 因為是同一架構,這兩張我都有玩過.... 終於找到關於他的型號... 只有型號喔...Orz... http://www.3ware.com/products/pdf/AM..._101906_FN.pdf G133 RAID Engine... 古老的架構... 2.由於3ware的這種StorSwitch架構的獨特性... 可以說是缺一不可.... Marvell產品可以說是疑點重重 官網上資訊簡陋.. 拿doc.看要簽NDA.... 此篇文章於 2010-07-02 09:54 PM 被 per1 編輯。. |

| 回覆 |

| PCDVD:vxr  | 回覆: RAID硬體資訊收集...!! 內容部分排版... 增加一些產品資訊.. 增加了對SAS的Dual-Port設計說明....  |

| 回覆 |

| XML | RSS 2.0 | RSS |

本論壇所有文章僅代表留言者個人意見,並不代表本站之立場,討論區以「即時留言」方式運作,故無法完全監察所有即時留言,若您發現文章可能有異議,請 email :[email protected] 處理。